3.2 Aplicação: Problema de Classificação Binária

Ajude a manter o site livre, gratuito e sem propagandas. Colabore!

Em construção

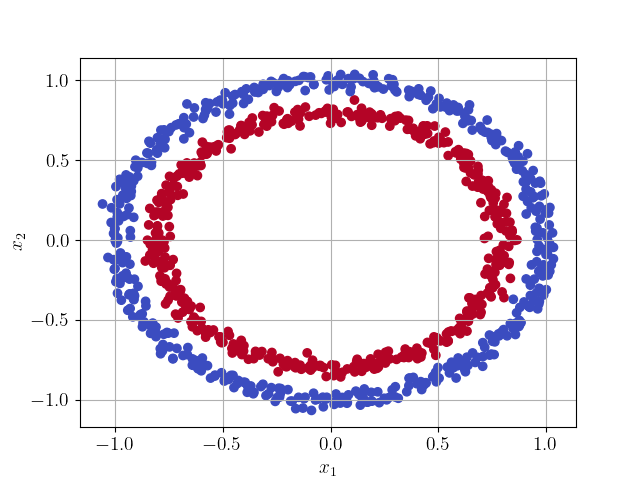

Vamos estudar uma aplicação de redes neurais artificiais em um problema de classificação binária não linear.

3.2.1 Dados

Em construção

Vamos desenvolver uma rede do tipo Perceptron Multicamadas (MLP) para a classificação binária de pontos, com base nos seguintes dados.

3.2.2 Modelo

Em construção

Vamos usar uma MLP de estrutura 2-10-1, com função de ativação

| (3.12) |

na camada escondida e

| (3.13) |

na saída da rede.

Para o treinamento e teste, vamos randomicamente separar os dados em um conjunto de treinamento e um conjunto de teste , com para os pontos azuis e para os pontos vermelhos.

3.2.3 Treinamento e Teste

Em construção

3.2.4 Verificação

Em construção

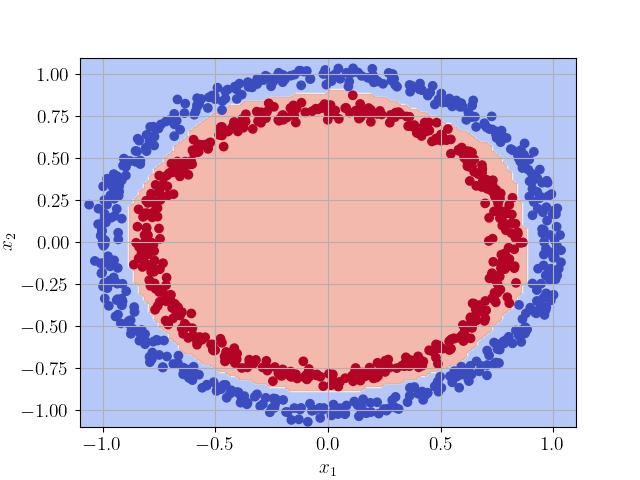

Para a verificação, testamos o modelo em uma malha uniforme de pontos no domínio . Consulte a Figure 3.3.

3.2.5 Exercícios

Em construção

Envie seu comentário

As informações preenchidas são enviadas por e-mail para o desenvolvedor do site e tratadas de forma privada. Consulte a Política de Uso de Dados para mais informações. Aproveito para agradecer a todas/os que de forma assídua ou esporádica contribuem enviando correções, sugestões e críticas!