4.1 Aplicação: Equação de Poisson

Ajude a manter o site livre, gratuito e sem propagandas. Colabore!

Vamos criar uma MLP para resolver o problema de Poisson1111endnote: 11Siméon Denis Poisson, 1781 - 1840, matemático francês. Fonte: Wikipédia:Siméon Denis Poisson.

| (4.1a) | |||

| (4.1b) |

com fonte dada

| (4.2) |

No treinamento, vamos usar a função erro baseada no resíduo da equação de Poisson (4.1a) e nas condições de contorno (4.1b). Mais especificamente, assumimos a função erro

| (4.3) |

onde o resíduo é definido por

| (4.4) |

A cada época, conjuntos de pontos e são randomicamente gerados com distribuição uniforme.

Observação 4.1.1.

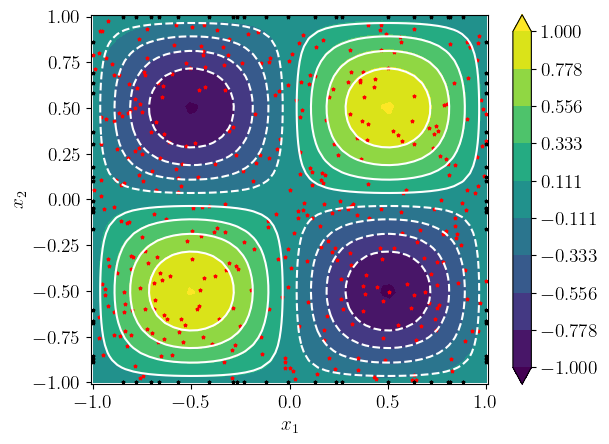

O problema de Poisson (4.1) tem solução analítica

| (4.5) |

É importante observar que o treinamento da MLP não depende de conhecermos a solução. Aqui, vamos usá-la apenas para compararmos a solução MLP com a analítica.

4.1.1 Exercícios

E. 4.1.1.

Crie uma MLP para resolver

| (4.6) | |||

| (4.7) | |||

| (4.8) | |||

| (4.9) | |||

| (4.10) |

Resposta.

Dica: solução analítica .

Envie seu comentário

As informações preenchidas são enviadas por e-mail para o desenvolvedor do site e tratadas de forma privada. Consulte a Política de Uso de Dados para mais informações. Aproveito para agradecer a todas/os que de forma assídua ou esporádica contribuem enviando correções, sugestões e críticas!